Przekształcanie danych - Data wrangling

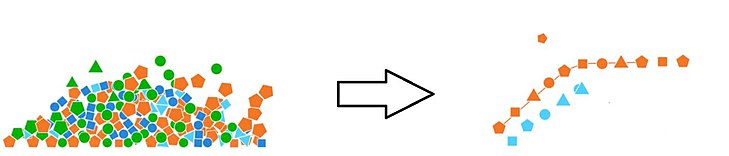

Dane spory , czasami określane jako munging dane , to proces przekształcania i mapowania danych z jednego „ surowej ” postaci danych do innego formatu z zamiarem uczynienie go bardziej odpowiednie i cenne dla różnych celów, takich jak dalszych analiz. Celem wymiany danych jest zapewnienie jakości i użytecznych danych. Analitycy danych zazwyczaj spędzają większość czasu na przepychaniu się danych w porównaniu z rzeczywistą analizą danych.

Proces przetwarzania danych może obejmować dalsze munging , wizualizację danych, agregację danych, uczenie modelu statystycznego , a także wiele innych potencjalnych zastosowań. Przetwarzanie danych zazwyczaj obejmuje zestaw ogólnych kroków, które rozpoczynają się od wyodrębnienia danych w surowej formie ze źródła danych, „umiejętności” surowych danych (np. sortowanie) lub parsowania danych do predefiniowanych struktur danych, a na końcu umieszczenia wynikowej treści w ujście danych do przechowywania i wykorzystania w przyszłości.

Tło

W „wrangler” nietechniczne określenie jest często mówi się, że pochodzą z pracy wykonanej przez Zjednoczone Biblioteka Kongresu Stanów z „s Krajowa Informacja cyfrowa Programu Infrastruktura i Preservation (NDIIPP) i ich programu partnerować Emory University Biblioteki opiera MetaArchive Partnerstwa. Termin „mung” ma korzenie w mungingu, jak opisano w Jargon File . Termin „wrangler danych” został również zasugerowany jako najlepsza analogia do opisania kogoś pracującego z danymi.

Jedną z pierwszych wzmianek o kłótni danych w kontekście naukowym był Donald Cline podczas eksperymentu NASA/NOAA Cold Lands Processes Experiment. Cline stwierdził, że administratorzy danych „koordynują gromadzenie całego zbioru danych eksperymentalnych”. Cline określa również obowiązki, którymi zwykle zajmuje się administrator pamięci masowej przy pracy z dużymi ilościami danych . Może to mieć miejsce w obszarach takich jak duże projekty badawcze i kręcenie filmów z dużą ilością złożonych obrazów generowanych komputerowo . W badaniach obejmuje to zarówno transfer danych z instrumentu badawczego do sieci pamięci masowej lub obiektu pamięci, jak i manipulację danymi w celu ponownej analizy za pomocą wysokowydajnych instrumentów obliczeniowych lub dostęp za pośrednictwem cyfrowych bibliotek opartych na infrastrukturze cybernetycznej .

Wraz z nadejściem sztucznej inteligencji w nauce o danych , coraz ważniejsze staje się, aby automatyzacja walki o dane miała bardzo rygorystyczne kontrole i balanse, dlatego proces mungingu danych nie został zautomatyzowany przez uczenie maszynowe . Zamazywanie danych wymaga czegoś więcej niż tylko zautomatyzowanego rozwiązania, wymaga wiedzy o tym, jakie informacje należy usunąć, a sztuczna inteligencja nie jest do tego stopnia, aby takie rzeczy zrozumieć.

Połączenie z eksploracją danych

Żądanie danych to nadzbiór eksploracji danych i wymaga procesów, z których korzystają, ale nie zawsze, niektóre eksploracje danych. Proces eksploracji danych polega na znajdowaniu wzorców w dużych zestawach danych, w których konflikty danych przekształcają dane w celu uzyskania wglądu w te dane. Mimo że walka o dane jest nadzbiorem eksploracji danych, nie oznacza to, że eksploracja danych z niej nie korzysta, istnieje wiele przypadków użycia danych w eksploracji danych. Aranżacja danych może przynieść korzyści w eksploracji danych, usuwając dane, które nie przynoszą korzyści całemu zestawowi lub nie są odpowiednio sformatowane, co przyniesie lepsze wyniki w całym procesie eksploracji danych.

Przykładem eksploracji danych, która jest ściśle związana z przepychaniem się danych, jest ignorowanie danych z zestawu, który nie jest powiązany z celem: powiedzmy, że istnieje zestaw danych związany ze stanem Teksas, a celem jest uzyskanie statystyk dotyczących mieszkańców Houston , dane w zbiorze dotyczące mieszkańców Dallas nie są przydatne dla całego zbioru i można je usunąć przed przetwarzaniem w celu poprawy wydajności procesu eksploracji danych.

Korzyści

Wraz ze wzrostem ilości surowych danych rośnie ilość danych, które nie są z natury przydatne, co wydłuża czas poświęcany na czyszczenie i porządkowanie danych przed ich analizą, w której w grę wchodzi przepychanie danych. Wynik konfliktu danych może dostarczyć ważnych statystyk metadanych dla dalszego wglądu w dane, ważne jest, aby upewnić się, że metadane są spójne, w przeciwnym razie może powodować blokady dróg. Wymiana danych pozwala analitykom szybciej analizować bardziej złożone dane, osiągać dokładniejsze wyniki, dzięki czemu można podejmować lepsze decyzje. Wiele firm przeszło na walkę o dane z powodu sukcesu, jaki przyniosła.

Podstawowe pomysły

Główne etapy wymiany danych są następujące:

-

- Odkrywanie

- Pierwszym krokiem w radzeniu sobie z danymi jest lepsze zrozumienie danych: różne dane są przetwarzane i organizowane na różne sposoby.

-

- Strukturyzacja

- Następnym krokiem jest uporządkowanie danych. Surowe dane są zazwyczaj niezorganizowane i wiele z nich może nie być przydatnych dla produktu końcowego. Ten krok jest ważny dla łatwiejszego obliczania i analizy w późniejszych krokach.

-

- Czyszczenie

- Istnieje wiele różnych form czyszczenia danych, na przykład jedna forma czyszczenia danych to przechwytywanie dat sformatowanych w inny sposób, a inna forma to usuwanie wartości odstających, które będą zniekształcać wyniki, a także formatowanie wartości pustych. Ten krok jest ważny dla zapewnienia ogólnej jakości danych.

-

- Wzbogacanie

- Na tym etapie należy określić, czy dodatkowe dane byłyby korzystne dla zestawu danych, który można łatwo dodać.

-

- Walidacja

- Ten krok jest podobny do strukturyzacji i czyszczenia. Używaj powtarzalnych sekwencji reguł walidacji, aby zapewnić spójność danych oraz jakość i bezpieczeństwo. Przykładem reguły walidacji jest potwierdzanie poprawności pól poprzez sprawdzanie krzyżowe danych.

-

- Wydawniczy

- Przygotuj zestaw danych do dalszego wykorzystania, co może obejmować wykorzystanie przez użytkowników lub oprogramowanie. Pamiętaj, aby udokumentować wszelkie kroki i logikę podczas kłótni.

Te kroki są procesem iteracyjnym, który powinien zapewnić czysty i użyteczny zestaw danych, który można następnie wykorzystać do analizy. Ten proces jest żmudny, ale satysfakcjonujący, ponieważ pozwala analitykom uzyskać potrzebne informacje z dużego zestawu danych, które w przeciwnym razie byłyby nieczytelne.

| Nazwa | Telefon | Data urodzenia | Stan |

|---|---|---|---|

| John Smith | 445-881-4478 | 12 sierpnia 1989 | Maine |

| Jennifer Tal | +1-189-456-4513 | 11.12.1965 | Tx |

| Bramy, Bill | (876)546-8165 | 15 czerwca 72 | Kansas |

| Alan Fitch | 5493156648 | 2-6-1985 | Oh |

| Jakub Alan | 156-4896 | 3 stycznia | Alabama |

| Nazwa | Telefon | Data urodzenia | Stan |

|---|---|---|---|

| John Smith | 445-881-4478 | 1989-08-12 | Maine |

| Jennifer Tal | 189-456-4513 | 1965-11-12 | Teksas |

| Bill Gates | 876-546-8165 | 1972-06-15 | Kansas |

| Alan Fitch | 549-315-6648 | 1985-02-06 | Ohio |

Wynik użycia procesu przetwarzania danych na tym małym zestawie danych pokazuje znacznie łatwiejszy do odczytania zestaw danych. Wszystkie nazwiska są teraz sformatowane w ten sam sposób, {imię, nazwisko}, numery telefonów są również sformatowane w ten sam sposób {numer kierunkowy-XXX-XXXX}, daty są sformatowane numerycznie {RRRR-mm-dd}, a stany nie są już skrócony. Wpis dotyczący Jacoba Alana nie zawierał w pełni uformowanych danych (brak numeru kierunkowego na numerze telefonu, a data urodzenia nie zawierała roku), więc został usunięty ze zbioru danych. Teraz, gdy wynikowy zestaw danych jest wyczyszczony i czytelny, jest gotowy do wdrożenia lub oceny.

Typowe zastosowanie

Przekształcenia danych są zwykle stosowane do odrębnych jednostek (np. pól, wierszy, kolumn, wartości danych itp.) w zestawie danych i mogą obejmować takie działania, jak wyodrębnianie, analizowanie, łączenie, standaryzacja, rozszerzanie, czyszczenie, konsolidacja i filtrowanie do tworzenia pożądanych wyników spornych, które można wykorzystać w dalszym ciągu.

Odbiorcami mogą być osoby fizyczne, takie jak architekci danych lub analitycy danych, którzy będą dalej badać dane, użytkownicy biznesowi, którzy będą konsumować dane bezpośrednio w raportach, lub systemy, które będą dalej przetwarzać dane i zapisywać je w celach takich jak hurtownie danych , dane jeziora lub aplikacje niższego rzędu.

Modus operandi

W zależności od ilości i formatu napływających danych, wymiana danych była tradycyjnie wykonywana ręcznie (np. za pomocą arkuszy kalkulacyjnych typu Excel), narzędzi typu KNIME lub za pomocą skryptów w językach takich jak Python czy SQL . R , język często używany w eksploracji danych i statystycznej analizie danych, jest obecnie również często używany do prowadzenia interesów. Administratorzy danych zazwyczaj mają zestawy umiejętności w zakresie: R lub Python, SQL, PHP, Scala i innych języków zwykle używanych do analizowania danych.

Systemy wizualnej wymiany danych zostały opracowane, aby ułatwić dostęp do danych osobom niebędącym programistami i prostsze dla programistów. Niektóre z nich obejmują również wbudowane rekomendacje AI i programowanie według przykładowych udogodnień zapewniających pomoc dla użytkownika oraz techniki syntezy programów do automatycznego generowania skalowalnego kodu przepływu danych. Wczesne prototypy narzędzi do przetwarzania danych wizualnych obejmują OpenRefine i system badawczy Stanford/Berkeley Wrangler ; ten ostatni przekształcił się w Trifacta .

Inne terminy dotyczące tych procesów obejmowały franczyzę danych, przygotowanie danych i przetwarzanie danych.

Przykład

Mając zestaw danych, który zawiera informacje o pacjentach medycznych, Twoim celem jest znalezienie korelacji z chorobą. Przed rozpoczęciem iteracji danych upewnij się, że rozumiesz wynik, czy szukasz pacjentów z chorobą? Czy istnieją inne choroby, które mogą być przyczyną? Po zrozumieniu wyniku można rozpocząć proces przepychania danych.

Zacznij od określenia struktury wyniku, co jest ważne dla zrozumienia diagnozy choroby.

Po ustaleniu ostatecznej struktury wyczyść dane, usuwając wszelkie punkty danych, które nie są pomocne lub są zniekształcone, może to obejmować pacjentów, u których nie zdiagnozowano żadnej choroby.

Po oczyszczeniu spójrz ponownie na dane, czy jest coś, co można dodać do znanego zestawu danych, co przyniosłoby korzyści? Przykładem mogą być najczęstsze choroby w okolicy, Ameryka i Indie bardzo się różnią, jeśli chodzi o najczęstsze choroby.

Teraz nadchodzi etap walidacji, określanie zasad walidacji, dla których punkty danych należy sprawdzić pod kątem ważności, może to obejmować datę urodzenia lub sprawdzenie pod kątem określonych chorób.

Po etapie walidacji dane powinny być teraz zorganizowane i przygotowane do wdrożenia lub oceny. Proces ten może być korzystny dla określenia korelacji dla diagnozy choroby, ponieważ zmniejszy ogromną ilość danych do czegoś, co można łatwo przeanalizować w celu uzyskania dokładnych wyników.