Uogólnienie kartograficzne - Cartographic generalization

Uogólnienie kartograficzne lub uogólnienie mapy obejmuje wszystkie zmiany na mapie, które są wprowadzane podczas tworzenia mapy w mniejszej skali z mapy lub danych mapy w większej skali lub odwrotnie. Jest to zasadnicza część projektowania kartograficznego . Niezależnie od tego, czy jest to wykonywane ręcznie przez kartografa, komputer lub zestaw algorytmów , uogólnienie ma na celu wyabstrahowanie informacji przestrzennych o wysokim poziomie szczegółowości do informacji, które mogą być renderowane na mapie na niższym poziomie szczegółowości. Na przykład możemy mieć zarysy wszystkich tysięcy budynków w regionie, ale chcemy zrobić mapę całego miasta o szerokości nie większej niż kilka cali. Zamiast wyrzucać informacje o budynku lub próbować renderować je wszystkie na raz, moglibyśmy uogólnić dane w pewien zarys obszaru zurbanizowanego regionu.

Kartograf ma licencję na dostosowanie treści na swoich mapach, aby stworzyć odpowiednią i użyteczną mapę, która przekazuje informacje przestrzenne, jednocześnie zachowując odpowiednią równowagę między celem mapy a dokładnymi szczegółami mapowanego obiektu. Mapy dobrze uogólnione to takie, które podkreślają najważniejsze elementy mapy, a jednocześnie przedstawiają świat w najbardziej wierny i rozpoznawalny sposób.

Historia

W pierwszej połowie XX wieku kartografowie zaczęli poważnie zastanawiać się, jak rysowane przez nich cechy zależą od skali. Eduard Imhof , jeden z najwybitniejszych ówczesnych kartografów akademickich i zawodowych, opublikował w 1937 r. studium planów miast na mapach w różnych skalach, wymieniając kilka form uogólnienia, które miały miejsce, w tym te później nazwane symbolizacją, łączeniem, uproszczeniem, wzmocnienie i przemieszczenie. Ponieważ w latach 50. i 60. pojawiły się analityczne podejścia do geografii, przedmiotem badań była generalizacja, zwłaszcza uproszczenie linii i wygładzanie rastra.

Generalizacja była prawdopodobnie najdokładniej zbadanym aspektem kartografii od lat 70. do 90. XX wieku. Dzieje się tak prawdopodobnie dlatego, że wpisuje się w oba główne nurty badawcze epoki: komunikację kartograficzną (zwłaszcza algorytmy przetwarzania sygnałów oparte na teorii informacji ) oraz możliwości, jakie daje postęp technologiczny (ze względu na jego potencjał automatyzacji). Wczesne badania koncentrowały się przede wszystkim na algorytmach automatyzacji poszczególnych operacji uogólniania. Pod koniec lat 80. kartografowie akademiccy myśleli szerzej, opracowując ogólną teorię uogólnienia i badając wykorzystanie systemów eksperckich i innych powstających technologii sztucznej inteligencji do automatyzacji całego procesu, w tym decyzji o tym, których narzędzi użyć i kiedy. Te utwory upadły nieco pod koniec lat 90., co zbiegło się z ogólną utratą wiary w obietnicę sztucznej inteligencji i wzrostem postmodernistycznej krytyki wpływu automatyzacji projektowania.

W ostatnich latach społeczność uogólniająca zaczęła się odradzać, napędzana częściowo nowymi możliwościami sztucznej inteligencji. Innym ostatnim trendem jest skupienie się na mapowaniu wieloskalowym , integrując bazy danych GIS opracowane dla kilku skal docelowych, zawężając zakres potrzeby generalizacji do „luk” między nimi, co jest łatwiejszym w zarządzaniu poziomem automatyzacji.

Teorie szczegółów mapy

Generalizacja jest często definiowana po prostu jako usuwanie szczegółów, ale opiera się na pojęciu pierwotnie przyjętym z teorii informacji , ilości informacji lub szczegółów znalezionych na mapie oraz tego, jak ta objętość jest kontrolowana przez skalę mapy, cel mapy i zamierzone publiczność. Jeżeli istnieje optymalna ilość informacji dla danego projektu mapy, to uogólnianiem jest proces pobierania istniejących dostępnych danych, często nazywany (zwłaszcza w Europie) cyfrowym modelem krajobrazu (DLM), który zwykle, choć nie zawsze, ma większą ilość informacje, niż są potrzebne, i przetworzenie ich w celu stworzenia nowego zbioru danych, często zwanego cyfrowym modelem kartograficznym (DCM), o pożądanej ilości.

Zaproponowano wiele ogólnych modeli koncepcyjnych do zrozumienia tego procesu, często próbując uchwycić proces decyzyjny ludzkiego mistrza kartografa. Jeden z najpopularniejszych modeli, opracowany przez McMastera i Shea w 1988 roku, dzieli te decyzje na trzy fazy: cele filozoficzne , ogólne powody, dla których generalizacja jest pożądana lub konieczna oraz kryteria oceny jej sukcesu; Ocena kartometryczna , charakterystyka danej mapy (lub obiektu na tej mapie), która wymaga uogólnienia; oraz Przekształcenia przestrzenne i atrybutowe , zbiór operatorów uogólniania dostępnych do użycia na danym obiekcie, warstwie lub mapie. W pierwszej, najbardziej koncepcyjnej fazie, McMaster i Shea pokazują, jak uogólnianie odgrywa kluczową rolę w rozwiązywaniu często sprzecznych celów projektowania kartograficznego jako całości: funkcjonalność kontra estetyka, bogactwo informacji kontra przejrzystość i chęć robienia więcej kontra. ograniczenia technologii i medium. Konflikty te można sprowadzić do podstawowego konfliktu między potrzebą większej ilości danych na mapie a potrzebą ich mniejszej ilości, przy czym narzędziem do ich równoważenia jest uogólnienie.

Jednym z wyzwań w podejściu teorii informacji do uogólniania jest jego podstawa do pomiaru ilości informacji na mapie, przed i po procedurach uogólniania. Można sobie wyobrazić mapę kwantyfikowaną przez jej gęstość informacji na mapie , średnią liczbę „bitów” informacji na jednostkę obszaru na mapie (lub jej następstwo, rozdzielczość informacji , średnią odległość między bitami) oraz przez jej gęstość informacji gruntowych lub rozdzielczość , te same miary na jednostkę powierzchni na Ziemi. Skala byłaby zatem proporcjonalna do stosunku między nimi, a zmiana skali wymagałaby dostosowania jednego lub obu z nich za pomocą uogólnienia.

Ale co liczy się jako „trochę” informacji na mapie? W szczególnych przypadkach nie jest to trudne, np. zliczanie całkowitej liczby obiektów na mapie lub liczby wierzchołków w jednej linii (ewentualnie zredukowanej do liczby wierzchołków najistotniejszych ); taka prostolinijność wyjaśnia, dlaczego były to wczesne cele badań uogólniających. Jest to jednak ogólnie wyzwanie dla mapy, w którym pojawiają się pytania typu „ile informacji graficznych znajduje się w etykiecie mapy: jeden bit (całe słowo), bit dla każdego znaku, bity dla każdego wierzchołka lub krzywą w każdym znaku, jakby były cechami każdego obszaru? Każda opcja może mieć znaczenie w różnym czasie.

Pomiar ten dodatkowo komplikuje rola symboliki mapy , która może wpływać na pozorną gęstość informacji . Mapa z silną hierarchią wizualną (tj. z mniej ważnymi warstwami, które są stonowane, ale nadal obecne) niesie ze sobą estetykę „czystości”, ponieważ na pierwszy rzut oka wydaje się, że zawiera mniej danych niż w rzeczywistości; odwrotnie, mapę bez hierarchii wizualnej, w której wszystkie warstwy wydają się równie ważne, można podsumować jako „zaśmieconą”, ponieważ pierwsze wrażenie jest takie, że zawiera więcej danych niż w rzeczywistości. Projektowanie mapy w celu osiągnięcia pożądanej estetyki gestalt polega zatem na zarządzaniu pozorną gęstością informacji bardziej niż rzeczywistą gęstością informacji. W słowach Edwarda Tufte ,

Zamieszanie i bałagan to błędy projektu, a nie atrybuty informacji. Chodzi więc o znalezienie strategii projektowych, które ujawniają szczegółowość i złożoność, a nie obwinianie danych o nadmiar komplikacji.

Ostatnio pojawiła się praca, która uznaje rolę symboli mapowych, w tym typologię operatorów uogólniania Roth-Brewera, chociaż wyjaśniają one, że symbolika nie jest formą uogólnienia, tylko partnerem z uogólnieniem w osiągnięciu pożądanej pozornej gęstości informacji.

Operatorzy

Istnieje wiele technik kartograficznych, które służą do dostosowania ilości danych geograficznych na mapie. W ciągu dziesięcioleci badań nad uogólnieniem opublikowano kilkanaście unikalnych list takich operatorów uogólniania , z istotnymi różnicami. W rzeczywistości istnieje wiele recenzji porównujących listy, a nawet brakuje kilku istotnych, takich jak ta znaleziona w pierwszym podręczniku Johna Keatesa (1973), który najwyraźniej wyprzedził swoje czasy. Niektóre z tych operacji zostały zautomatyzowane przez wiele algorytmów, z narzędziami dostępnymi w systemach informacji geograficznej i innym oprogramowaniu; inne okazały się znacznie trudniejsze, a większość kartografów nadal wykonuje je ręcznie.

Wybierz

Nazywany również filtrem, pominięcie

Jednym z pierwszych rozpoznanych i przeanalizowanych operatorów, pojawiających się po raz pierwszy na liście Keatesa z 1973 roku, jest proces polegający na prostym usuwaniu z mapy całych obiektów geograficznych. Istnieją dwa rodzaje selekcji, które w niektórych modelach są łączone, aw innych rozdzielane:

- Wybór warstwy : (nazywany również wyborem klasy lub dodawaniem ) wybór warstw danych lub tematów do uwzględnienia lub nie (na przykład mapa ulic zawierająca ulice, ale nie geologię).

- Wybór funkcji : (nazywany czasem udoskonalaniem lub eliminacją ) wybór konkretnych obiektów do uwzględnienia lub usunięcia w dołączonych warstwach (na przykład, które 50 z milionów miast ma być pokazane na mapie świata).

W wyborze funkcji wybór, które funkcje zachować lub wykluczyć, jest trudniejszy, niż mogłoby się wydawać. Użycie prostego atrybutu rzeczywistego rozmiaru (liczba ludności, szerokość drogi lub natężenie ruchu, natężenie przepływu rzeki), choć często łatwo dostępne w istniejących danych GIS, często daje wybór, który jest nadmiernie skoncentrowany w niektórych obszarach, a rzadki w innych. W związku z tym kartografowie często filtrują je, biorąc pod uwagę stopień ich znaczenia regionalnego , ich widoczność w lokalnym obszarze, a nie mapę jako całość, co daje bardziej zrównoważoną mapę, ale trudniej ją zautomatyzować. Opracowano wiele wzorów do automatycznego uszeregowania regionalnego znaczenia obiektów, na przykład poprzez zrównoważenie surowego rozmiaru z odległością do najbliższej cechy o znacznie większym rozmiarze, podobnie jak w przypadku miar wyróżnienia topograficznego , ale jest to znacznie trudniejsze dla obiektów liniowych niż punktów, a czasami powoduje niepożądane rezultaty (takie jak „Problem Baltimore”, w którym pomija się miasta, które wydają się ważne).

Innym podejściem jest ręczne kodowanie subiektywnej oceny o znaczeniu regionalnym do danych GIS, które można następnie wykorzystać do filtrowania cech; takie podejście przyjęto dla zbioru danych Natural Earth stworzonego przez kartografów.

Uproszczać

Innym wczesnym celem badań nad uogólnieniem, uproszczeniem, jest usuwanie wierzchołków w liniach i granicach obszarów. Opracowano różne algorytmy, ale większość z nich polega na przeszukiwaniu wierzchołków linii, usuwając te, które w najmniejszym stopniu przyczyniają się do ogólnego kształtu linii. Algorytm Ramer-Douglas-Peucker (1972/1973) jest jednym z pierwszych i wciąż Najczęstsze techniki linii uproszczenia. Większość z tych algorytmów, zwłaszcza te wczesne, kładła większy nacisk na zmniejszenie rozmiaru zbiorów danych w czasach ograniczonej pamięci cyfrowej niż na jakość wyglądu na mapach i często tworzyły linie, które wyglądają na nadmiernie kanciaste, zwłaszcza na zakrętach, takich jak rzeki .

Gładki

W przypadku obiektów liniowych (i granic obszarów) wygładzanie wydaje się być podobne do uproszczenia, a w przeszłości było czasem łączone z uproszczeniem. Różnica polega na tym, że wygładzanie ma na celu uproszczenie ogólnego kształtu linii poprzez usunięcie drobnych szczegółów; które w rzeczywistości mogą wymagać więcej wierzchołków niż oryginał. Uproszczenie sprawia, że zakrzywiona linia wygląda na kanciastą, podczas gdy wygładzanie działa odwrotnie.

Zasada wygładzania jest również często używana do uogólniania rastrowych reprezentacji pól , często przy użyciu podejścia Kernel smoother . W rzeczywistości był to jeden z pierwszych opublikowanych algorytmów uogólniania, autorstwa Waldo Toblera w 1966 roku.

Łączyć

Nazywany również rozpuszczaniem, amalgamacją, aglomeracją lub łączeniem

Operacja ta, zidentyfikowana przez Imhofa w 1937 roku, polega na łączeniu sąsiednich cech w jedną cechę tego samego typu, w skalach, w których rozróżnienie między nimi nie jest istotne. Na przykład łańcuch górski może składać się z kilku odizolowanych grzbietów w środowisku naturalnym, ale pokazanych na mapie jako ciągły łańcuch w małej skali. Lub sąsiadujące budynki w kompleksie można połączyć w jeden „budynek”. W celu prawidłowej interpretacji czytelnik mapy musi mieć świadomość, że ze względu na ograniczenia skali połączone elementy nie są doskonałymi odzwierciedleniem cech naturalnych lub stworzonych przez człowieka. Dissolve jest powszechnym narzędziem GIS używanym do tej operacji uogólniania, ale dodatkowe narzędzia Narzędzia GIS zostały opracowane dla określonych sytuacji, takich jak znajdowanie bardzo małych wielokątów i łączenie ich w sąsiednie większe wielokąty. Ten operator różni się od agregacji, ponieważ nie ma zmiany w wymiarowości (tj. linie są rozpuszczane w linie, a wielokąty w wielokąty), a oryginalne i końcowe obiekty są tego samego typu pojęciowego (np. budynek staje się budynkiem).

Agregat

Nazywany również kombajnem lub regionalizacją

Agregacja to połączenie wielu elementów w nowy element złożony, często o zwiększonym Wymiarze (zwykle wskazuje na obszary). Nowa cecha ma inny charakter ontologiczny niż pierwotne jednostki, ponieważ konceptualizuje grupę. Na przykład wiele „budynków” można przekształcić w jeden region reprezentujący „obszar miejski” (nie „budynek”) lub skupisko „drzew” w „las”. Niektóre oprogramowanie GIS posiada narzędzia do agregacji, które identyfikują klastry funkcji i łączą je. Agregacja różni się od scalania tym, że może działać w różnych wymiarach, na przykład agregować punkty z liniami, punkty z wielokątami, linie z wielokątami i wielokąty z wielokątami, oraz że istnieje koncepcyjna różnica między źródłem a produktem.

Charakteryzować

Nazywany również udoskonalaniem dystrybucji

Typify to operator symboliki, który zastępuje duży zestaw podobnych funkcji mniejszą liczbą symboli reprezentatywnych, co skutkuje rzadszą, czystszą mapą. Na przykład obszar z dziesiątkami min może być symbolizowany tylko 3 lub 4 symbolami min, które nie reprezentują rzeczywistych lokalizacji min, a jedynie ogólną obecność min na danym obszarze. W przeciwieństwie do operatora agregacji, który zastępuje wiele powiązanych cech pojedynczą cechą „grupy”, symbole używane w operatorze typify nadal reprezentują indywidua, po prostu „typowe” indywidua. Zmniejsza gęstość funkcji, zachowując przy tym względną lokalizację i konstrukcję. Przy użyciu operatora typify tworzony jest nowy zestaw symboli, nie zmienia on danych przestrzennych. Ten operator może być używany na obiektach typu punkt, linia i wielokąt.

Zawalić się

Nazywany również symbolizować

Ten operator redukuje Wymiar obiektu, tak jak powszechna praktyka przedstawiania miast (2-wymiarowych) jako punktów (0-wymiarowych) i dróg (2-wymiarowych) jako linii (1-wymiarowych). Często symbol mapy jest stosowany do wynikowej geometrii, aby dać ogólne wskazanie jej pierwotnego zasięgu, takie jak średnica punktu reprezentująca populację miasta lub grubość linii reprezentująca liczbę pasów na drodze. Imhof (1937) szczegółowo omawia te szczególne uogólnienia. Operator ten często naśladuje podobną praktykę uogólniania poznawczego. Na przykład jednoznaczne omówienie odległości między dwoma miastami implikuje punktową konceptualizację miasta, a używanie wyrażeń takich jak „w górę drogi” lub „wzdłuż drogi”, a nawet adresów ulic implikuje liniową konceptualizację drogi.

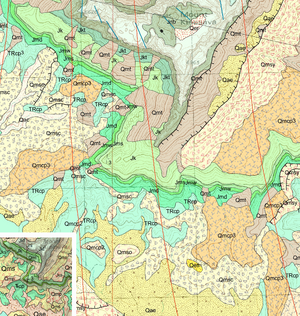

Przeklasyfikuj

Ten operator przede wszystkim upraszcza atrybuty cech, chociaż może również skutkować uproszczeniem geometrycznym. Chociaż kategoryzacja jest używana do wielu różnych celów, w tym przypadku zadaniem jest wzięcie dużego zakresu wartości, które są zbyt złożone, aby przedstawić je na mapie w danej skali, i zredukowanie go do kilku kategorii, które są znacznie prostsze do reprezentować, zwłaszcza jeśli wzorce geograficzne skutkują dużymi regionami tej samej kategorii. Przykładem może być wzięcie warstwy pokrycia terenu ze 120 kategoriami i pogrupowanie ich w 5 kategorii (miejskie, rolnicze, leśne, wodne, pustynne), co uprościłoby przestrzennie mapę. Dla dyskretnych pól (znany również jako kategoryczne pokryć lub map obszar-klasa) reprezentowane wielokątów wektorowych , takich jak pokrycia terenu , rodzaju klimatu , rodzaju gleby , miasta stref lub geologii powierzchniowej , przeklasyfikowania często prowadzi do sąsiednich poligonów z tej samej kategorii, co wymaga kolejna operacja rozpuszczania, aby je scalić.

Wyolbrzymiać

Przesada to częściowe dostosowanie geometrii lub symboliki, aby jakiś aspekt cechy był większy niż jest w rzeczywistości, w celu uczynienia go bardziej widocznym, rozpoznawalnym lub wyższym w hierarchii wizualnej . Na przykład zestaw ciasnych serpentyn na drodze biegnie razem na małej mapie, więc droga jest przerysowana z pętlami większymi i bardziej oddalonymi od siebie niż w rzeczywistości. Przykładem symboliki może być rysowanie autostrad jako grubych linii na mapie w małej skali, która miałaby mile szerokość, gdyby była mierzona zgodnie ze skalą. Przesada często wymusza późniejszą operację przemieszczenia, ponieważ przesadna cecha nakłada się na rzeczywistą lokalizację pobliskich cech, co wymaga ich dostosowania.

Wypierać

Nazywany również rozwiązywaniem konfliktów

Przemieszczenie można zastosować, gdy dwa obiekty są tak blisko siebie, że nakładają się na siebie w mniejszej skali, zwłaszcza gdy przesadny operator uczynił te dwa obiekty większymi niż są w rzeczywistości. Powszechnym miejscem, w którym miałoby to miejsce, są miasta Brazzaville i Kinszasa po obu stronach rzeki Kongo w Afryce. Są zarówno stolicą swojego kraju, jak i na mapach poglądowych będą wyświetlane z nieco większym symbolem niż inne miasta. W zależności od skali mapy symbole nakładałyby się na siebie. Przesuwając oba z nich z dala od rzeki (i z dala od ich rzeczywistego położenia), można uniknąć nakładania się symboli. Innym częstym przypadkiem jest sytuacja, gdy droga i linia kolejowa biegną równolegle do siebie. Keates (1973) był jednym z pierwszych, którzy użyli współczesnych terminów dla przesady i przemieszczenia oraz omówili ich bliski związek, ale zostali rozpoznani już w Imhofie (1937)

Zwiększyć

Jest to dodanie symboli lub innych szczegółów na mapie o mniejszej skali, aby konkretna funkcja była bardziej sensowna, zwłaszcza gdy takie zrozumienie jest ważne dla celu mapy. Typowym przykładem jest dodanie symbolu mostu w celu podkreślenia, że przejście drogowe nie jest na poziomie, ale jest wiaduktem . Na dużą skalę taki symbol może nie być konieczny ze względu na różną symbolikę i zwiększoną przestrzeń do pokazania rzeczywistego związku. To dodanie może wydawać się sprzeczne z intuicją, jeśli myślimy o uogólnieniu jako usuwaniu szczegółów. Jest to jeden z najrzadziej wymienianych operatorów.

GIS i automatyczna generalizacja

Wraz z rozwojem GIS od około końca lat sześćdziesiątych, potrzeba automatycznych, algorytmicznych technik uogólniania stała się jasna. Idealnie, agencje odpowiedzialne za zbieranie i przechowywanie danych przestrzennych powinny starać się zachować tylko jedną kanoniczną reprezentację danej cechy, na możliwie najwyższym poziomie szczegółowości. W ten sposób jest tylko jeden rekord do zaktualizowania, gdy ta funkcja zmieni się w świecie rzeczywistym. Z tych wielkoskalowych danych najlepiej byłoby, dzięki automatycznemu uogólnieniu, stworzyć mapy i inne produkty danych w dowolnej wymaganej skali. Alternatywą jest utrzymywanie osobnych baz danych, każda w skali wymaganej dla danego zestawu projektów mapowania, z których każdy wymaga uwagi, gdy coś się zmienia w świecie rzeczywistym.

W tym czasie opracowano kilka szerokich podejść do uogólniania:

- Reprezentacja zorientowany widok skupia się na reprezentacji danych na różnych skalach, co jest związane z dziedziny Wielu reprezentacji baz danych (MRDB).

- Proces zorientowany widok skupia się na procesie uogólnienia.

- Podejście drabinkowe jest stopniowym uogólnieniem, w którym każdy wyprowadzony zestaw danych jest oparty na innej bazie danych o kolejnej większej skali.

- Podejście gwiazdowe polega na tym, że dane pochodne we wszystkich skalach są oparte na jednej (w dużej skali) bazie danych.

Prawo skalowania

Na powierzchni Ziemi jest znacznie więcej małych obiektów geograficznych niż dużych, lub znacznie więcej małych obiektów niż dużych na mapach. To pojęcie o znacznie większej liczbie małych rzeczy niż dużych jest również nazywane niejednorodnością przestrzenną, która została sformułowana jako prawo skalowania. Generalizacja kartograficzna lub ogólnie wszelkie praktyki mapowania polegają zasadniczo na zachowaniu bazowego skalowania wielu najmniejszych, bardzo niewielu największych i niektórych pomiędzy najmniejszymi a największymi. Ten proces mapowania można wydajnie i skutecznie zrealizować za pomocą funkcji head/tail breaks , nowego schematu klasyfikacji lub narzędzia do wizualizacji danych z gęstym rozkładem ogonowym. Prawo skalujące prawdopodobnie zastąpi radykalne prawo Töpfera, stając się uniwersalnym prawem dla różnych praktyk mapowania. To, co leży u podstaw prawa skalowania, to coś w rodzaju zmiany paradygmatu z geometrii euklidesowej na fraktalną, od myślenia nierekurencyjnego do myślenia rekurencyjnego.

„Fenomen Baltimore”

Zjawisko Baltimore to tendencja do pomijania miasta (lub innego obiektu) na mapach ze względu na ograniczenia przestrzenne, podczas gdy mniejsze miasta są umieszczane na tej samej mapie tylko dlatego, że jest dostępne miejsce do ich wyświetlenia. Zjawisko to zawdzięcza swoją nazwę miastu Baltimore w stanie Maryland , które jest zwykle pomijane na mapach ze względu na obecność większych miast w bliskim sąsiedztwie w obrębie środkowoatlantyckich Stanów Zjednoczonych. Ponieważ na mapach pojawiają się większe miasta w pobliżu Baltimore, mniejsze i mniej znane miasta mogą również pojawiać się w tej samej skali, ponieważ jest dla nich wystarczająco dużo miejsca na mapie.

Chociaż zjawisko Baltimore występuje częściej na zautomatyzowanych stronach mapowych, nie występuje w każdej skali. Popularne witryny mapowe, takie jak Google Maps, Bing Maps, OpenStreetMap i Yahoo Maps, zaczną wyświetlać Baltimore dopiero przy określonych poziomach powiększenia: 5, 6, 7 itd.

Zobacz też

Bibliografia

Dalsza lektura

- Buttenfield, BP i McMaster, RB (red.). (1991). Generalizacja map: tworzenie reguł reprezentacji wiedzy . Nowy Jork: John Wiley i synowie.

- Harrie, L. (2003). Ustalanie wagi i ocena jakości przy jednoczesnej generalizacji graficznej. Dziennik kartograficzny , 40(3), 221-233.

- Lonergan, M. i Jones, CB (2001). Iteracyjna metoda przemieszczenia do rozwiązywania konfliktów w generalizacji map. Algorytmika , 30, 287-301.

- Li, Z. (2006). Algorytmiczne podstawy wieloskalowej reprezentacji przestrzennej . Boca Raton: CRC Press.

- Qi, H. i Zhaloi, L. (2004). Postęp w badaniach nad automatyczną generalizacją przestrzennego skupienia punktowego. Listy IEEE dotyczące teledetekcji , 2994, 2841–2844.

- Burdziej J., Gawrysiak P. (2012) Wykorzystanie eksploracji sieci do odkrywania wzorców przestrzennych i gorących punktów do generalizacji przestrzennej. W: Chen L., Felfernig A., Liu J., Raś ZW (red.) Podstawy inteligentnych systemów. ISMIS 2012. Notatki z wykładu z informatyki, vol 7661. Springer, Berlin, Heidelberg

- Jiang B. i Yin J. (2014), Ht-index do ilościowego określania struktury fraktalnej lub skalowania obiektów geograficznych, Annals of the Association of American Geographers , 104(3), 530-541.

- Jiang B., Liu X. i Jia T. (2013), Skalowanie przestrzeni geograficznej jako uniwersalna reguła generalizacji map, Annals of the Association of American Geographers , 103(4), 844-855.

- Chrobak T., Szombara S., Kozioł K., Lupa M. (2017), Metoda oceny uogólnionej dokładności danych z weryfikacją rozdzielczości obiektu liniowego, Geocarto International , 32(3), 238–256.